IS-O CONSULTING

Unternehmensberatung zur IT-Unternehmens-Nutzen/Kosten-Optimierung

Einführung →Zusammenfassung in Präsentations-Form →Darstellung Beschreibungs-Form Kurze Skizzierung der Vorteile "großer Organisations-Einheiten" Wieso konnte die IBM die Vorteile der überlegenden "großen Organisations-Einheit MF" seit ca. 20 Jahren nicht mehr überzeugend durchsetzen? Bedeutung des MF für die Unternehmens-IT der dt. VB in Kennzahlen Realisierung der Erkenntnisse vom überlegenen Preis/Leistungs-Verhältnis des MF auf "Best-Practice-Niveau" Einspar-Potential für ein einzelnes Versicherungs-Unternehmen und Geschäfts-Potential durch Einsatz des MF auf Best-Practice-Niveau: Eine Winners-only Lösung Vergleich der beiden wichtigsten Computer-Architektur-Alternativen der Gegenwart "MF" und "x86-Server" auf einem "dynamischen Bierdeckel" Unterstützung durch IS-O Consulting Einordnung dieses Themas in das IS-OC Consulting Know-how-Portfolio und die Bedeutung für die IT-Branche Kommunikation Seitenanfang

Die Rehabilitierung des Mainframe:

Durch Data-Mining bewiesene Überlegenheit des Mainframe für Kommerzielle Arbeitslast

Einführung

Dass "große Organisations-Einheiten" effektiver sind als kleine ist eigentlich eine triviale Erkenntnis, die jeder von uns schon aus dem Alltag kennt und die sich ganz leicht auch theoretisch untermauern lässt.Die Vorteile großer Organisations-Einheiten bestehen insbesondere in

- Synergie-Effekten gegenüber einer "Summe kleiner Organisations-Einheiten mit gleichem Output",

- Skalen- und Skalierungs-Vorteilen.

- Containerschiffe werden immer größer gebaut, gegenwärtig schon bis ca. 19.000 TEU, weil dadurch die Transport-Kosten pro TEU immer weiter sinken.

- Im Straßenverkehr sind bei Autobussen die Kosten pro Passagier-Kilometer wesentlich niedriger als bei Taxen.

- Große Automobilhersteller produzieren kostengünstiger als kleine Automobilhersteller.

- Große Staaten haben Wettbewerbsvorteile gegenüber kleinen Staaten: In Europa haben sich deshalb die in der Mehrheit relativ kleinen Staaten zur EU zusammengeschlossen, um gegenüber den USA und längerfristig auch gegenüber China wettbewerbsfähig zu bleiben.

- Und last-not-least: Die großen Lebewesen, wie Löwen, Haie, Adler und auch die Gattung Mensch, stehen bekanntlich an der "Spitze der Nahrungsketten".

In der Informationsverarbeitungs-Branche kommen sogar noch weitere Potentiale hinzu, nämlich:

- Homogenitäts- und Migrations-Vorteile sowie

- Produktivitäts-Vorteile durch umfangreiche "Productivityware", bei IBM Middleware genannt.

Dass dieser holistische Analyseansatz auch die Vorteile der "großen IT-Organisationseinheit Mainframe" zutage fördert, ist wissenschaftlich betrachtet eine triviale Selbstverständlichkeit. Äußerst erstaunlich ist bei diesem generellen Erkenntnisstand, dass es in der IT-Branche bisher den IT-Produkte-Anbietern, die nur "kleine IT-Organisationseinheiten wie Unix- und x86-Server" in ihrem Angebot haben, in den letzten ca. 20 Jahren gelungen ist, den IT-Anwendern diese ökonomische Grundgesetzmäßigkeit durch geschicktes Marketing zu verschleiern und sie damit zu unnötig hohen IT-Ausgaben zu verleiten! Da kann man die Anbieter der großen IT-Organisationseinheit Mainframe von einer Mitschuld offensichtlich nicht freisprechen.

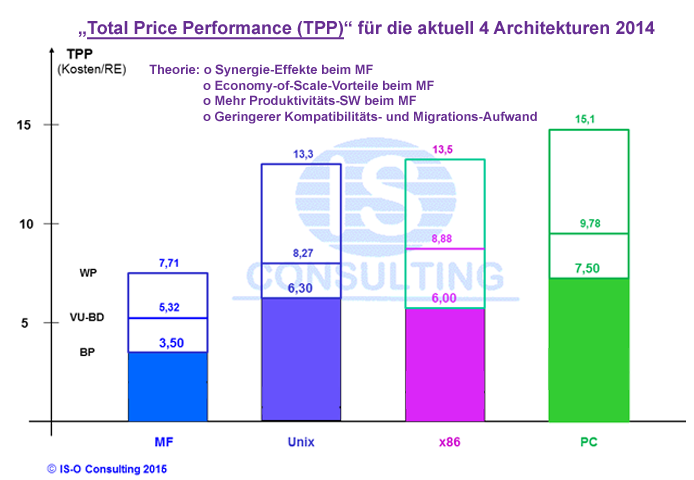

Die weiteren Potentiale der "großen IT-Organisationseinheit Mainframe" werden in der Ökonomie der "Totalen Faktor-Produktivität (TFP)" zugerechnet, da sie zusätzlich zu den Produktionsfaktoren "Arbeit" und "Kapital" auftreten und den "technischen und organisatorischen Fortschritt" abbilden. (siehe auch Wikipedia: "Totale Faktorproduktivität"). Aus den Unterschieden der TFP der verschiedenen Computer-Architekturen ergeben sich abgeleitet die Erkenntnisse, die als "Totales Preis/Leistungsverhältnis (TPP)" dargestellt werden können. Der Maßstab TPP ist nach unserer Erfahrung der best-geeignete bei der Beantwortung der Frage nach der preisgünstigsten Verteilung der Unternehmens-IT-Arbeitslast auf die gegenwärtig bis zu 4 zur Verfügung stehenden Computer-Architekturen.

Bei der fehlerhaften Verteilung der IT-Arbeitslast auf die verschiedenen Computer leistet auch ein der Evolution der Unternehmens-IT (UIT) hinterher hinkendes Verständnis der UIT Vorschub, da es die Unternehmens-IT als scheinbar immer noch nur aus Einzel-Computer-Lösungen bestehend abbildet, über die mittels singulärer "Produkt-Exzellenz-Kriterien" Entscheidungen getroffen werden können: Die dabei i.d.R. verwendeten "singulären, induktiven Entscheidungs-Modelle" führen dabei unausweichlich zu Fehlentscheidungen!

Notwendig ist stattdessen, schon seit Jahrzehnten, die Unternehmens-IT als "Produktions-Einrichtung" für die von den Unternehmen, ihren Mitarbeitern und Kunden, benötigten Informationen zu behandeln und IT-Entscheidungen ausschließlich nach holistischen betriebswirtschaftlichen Erkenntnissen zu treffen: Die in der UIP wichtigste lautet: Die IT-Produktionskosten sind pro Computer-Architektur zu ermitteln nach folgender Formel:

"Kosten des UIT-Output der eingesetzte Computer-Architektur" =

"Kosten des UIT-Output der eingesetzte Computer-Architektur" =- "Kosten der eingesetzten Computer-Architektur-Werkzeuge" plus

- "Betriebskosten" plus

- "Kosten der Anzahl der zur Produktion auf der Computer-Architektur benötigten IT-Beschäftigten".

Insbesondere die unterschiedliche TFP der verschiedenen Computer-Architekturen führt zu einer sehr unterschiedliche Anzahl an IT-Mitarbeitern, die bei der Produktion durch die gegenwärtig eingesetzten bis zu 4 Computer-Architekturen "Mainframe", "Unix-Server", "x86-Server" und "Client/Server+PC" benötigt werden. Diese prägen aber die Kosten des UIP-Outputs fundamental, da die IT-Personal-Kosten inzwischen (2014) den mit großem Abstand größten Kostenblock der IT-Budgets darstellen, z.B. in der deutschen Versicherungs-Branche im Branchendurchschnitt 55,8% mit weiter steigender Tendenz.

In dieser Gemengelage bleibt nicht nur die Erkenntnis auf der Strecke, dass z.B. in der deutschen Versicherungsbranche der MF gegenwärtig bei bis zu mindestens 70% der kommerziellen Unternehmens-Workload (UWL) das "Beste Totale Preis/Leistungs-Verhältnis" aufweist sondern sie hat auch dazu geführt, dass in dieser Branche auf dem MF im Jahre 2014 im Branchendurchschnitt nur noch 48,3% der WL produziert wird. Die dadurch unnötig verursachten Kosten, also bilanziert, betragen ca. € 207,6 Millionen pro Jahr und das nicht realisierte MF Geschäfts-Potential liegt bei mindestens etwa € 76,0 Millionen pro Jahr, davon 78,7% SSW-Umsatz, mit weiter steigender Tendenz. D.h., wir haben es hier mit einer schier unfassbaren "Losers-only"-Situation zu tun!

Mit dem von uns entwickelten Lösungs-Ansatz ist es neuerdings möglich, auch diese IT-Unternehmens-Nutzen-Potentiale Unternehmens-individuell in eine "Winners-only"-Situation weiterzuentwickeln.

Strategischer Hinweis zur Vertiefung dieser Erkenntnisse:

Nach Diskussion mit unserer "Kollaborativen Community" haben wir entschieden, unsere Erkenntnisse in 2 Versionen anzubieten:

- Als Zusammenfassung in Präsentations-Form mit Verlinkung und

- In Beschreibungs-Form.

Zusammenfassung in Präsentations-Form

Darstellung in Beschreibungs-Form

Kurze Skizzierung der Vorteile "großer Organisations-Einheiten"

Da die "Semantik der Vorteils-Elemente des MF" möglicherweise nicht allen Interessenten in ihrer ganzen Breite und Tiefe geläufig sein könnte, ihre genaue Kenntnis für das Verständnis unserer Erkenntnisse und für eine Diskussion über Realisierungsmöglichkeiten aber von hoher Bedeutung ist, möchten wir sie in ihrem Wesen anschließend kurz skizzieren. Wer alle Vorteils-Elemente ausreichend kennt, kann das nachfolgende Kapitel überspringen und mit (Wieso konnte die IBM die Vorteile der überlegenden "großen Organisations-Einheit MF" seit ca. 25 Jahren nicht mehr überzeugend durchsetzen?) fortfahren.

Synergie-Effekte

entstehen klassischerweise, wenn ein "kleines passendes Unternehmen" in ein großes Unternehmen integriert wird: Dann entfallen z.B. die meisten Stabsabteilungen und auch Fertigung und Vertrieb können effizienter organisiert werden. Die wichtigste Erkenntnis, die aus den Synergie-Effekten gezogen werden sollte, heißt, dass es sich bei professioneller Vorgehensweise um eine "Integration" handelt und nicht um eine "simple Addition"! Der Unterschied ist in der Kosten/Nutzen-Bilanz ganz erheblich: Während "Integrationskosten in der Nähe der Grenzkosten" angesiedelt sind handelt es sich bei den "Additionskosten um die wesentlich höheren Vollkosten!"

Erstaunlicherweise wird seit mehr als einem Jahrzehnt für die Auswahl der ökonomisch besten Computer für eine neue Anwendung der "theoretisch nachweislich ungeeignete Maßstab TCO" verwendet, auch von IBM: Da dieser Maßstab in seiner Erkenntnissubstanz ein "Bottom-up-Ansatz" ist, kann er nur Additionskosten darstellen und liefert somit unkorrigierbar falsche, jedwede Groß-Organisation, also nicht nur den Mainframe, benachteiligende Ergebnisse!

Beispiele für "Skalen- und Skalierungs-Vorteile"

finden sich zuhauf: Nicht nur bei den Unternehmen der Wirtschaft, sondern auch bei den Staaten dieser Welt und nicht zuletzt in der Tierwelt: Wir sind bei unseren Quellenstudien noch nie auf Erkenntnisse gestoßen, die wissenschaftlich belegen, dass diese "fundamentale Gesetzmäßigkeit der Organisation unserer Welt" ausgerechnet für die "IT-Welt" keine Gültigkeit haben sollte.

In der UIT-Welt wirken Skalen- und Skalierungs-Vorteile v.a. in 2 Bereichen: Der "Grundausrüstung der UIT mit den benötigten Computer-Funktionen in HW, SSW und IT-Personal" und im "Bereich der Anwendungen". Die Skalen-Vorteile bei der Grundausrüstung der UIT ergeben sich bei zunehmender Größe aus der Aufteilung der Kosten Grundausrüstung auf eine größere Anzahl an Anwendern und damit einer Verringerung der Kosten für den einzelnen Anwender. Des Weiteren rechnen sich mit zunehmender Größe auch Investitionen in eher selten benötigte aber wertvolle Funktionen. Bei den Anwendungen ergeben sich v.a. Skalierungs-Vorteile, am Existenz-Beginn einer Anwendung, wenn erst eine geringe Anzahl von Benutzern die Anwendung benutzt und auch gegen Lebensende der Anwendung, wenn die Anwendung noch nicht abgeschaltet werden kann. Wenn Anwendungen auf speziellen Servern ausgeführt werden, führt das i.d.R. unvermeidlich zu geringer Auslastung und eingeschränkter Funktionalität.

Homogenitäts- und Migrations-Vorteile

sind in der Informationsverarbeitung alles andere als unwesentliche Größen, die allerdings bei den üblichen, stark "Zeitpunkt-geprägten Entscheidungs-Situationen" viel zu wenig berücksichtigt werden. In der Informationsverarbeitung gibt es bekanntlich 2 antipodische Realisierungs-Philosophien: Die "alles aus einer Hand Lösung" und die "Kombination der Besten Einzelkomponenten-Lösung": Die "Befürworter" der 2. Alternative sind bekanntlich und sofort verständlich v.a. "Start-up Firmen" aber auch "IT-Funktions-Spezialisten", die in der Regel in der Tat zu einem gewissen Zeitpunkt eine bessere und/oder preiswertere Einzel-Funktionalität anbieten als "All-Inclusive-Anbieter". Wegen ihrer eingeschränkten Produkt- und damit auch Interessen-Perspektive vernachlässigen sie aber i.d.R. unvermeidlich das Interesse der Unternehmen, die "IT-Gesamt-System-Betreiber" sind und für die deshalb eine nicht nur gegenwärtig sondern auch in die weite Zukunft reichende absolut zuverlässige und preiswert bleibende Lösungskonzeption hohe Bedeutung hat. Daraus entstehen, in der Praxis unvermeidlich, Homogenitäts- und Migrations-Nachteile, die zum Zeitpunkt einer Einzelentscheidung nicht beurteilbar sind, auch von den Anbietern der Einzel-Komponenten nicht, und deshalb von den Einzel-Komponenten-Anbietern i.d.R. marketing-geprägt banalisiert werden. Als Beispiel stelle man sich vor, das preiswerteste Automobil bestehe aus folgenden wesentlichen Komponenten: Einer Karosserie vom Daimler, einem Motor von BMW, einem Fahrwerk von Audi usw. und dieses Gebilde würde von Toyota zusammengebaut und vermarktet. Wie viele solche Gebilde würden wohl abgesetzt? Wie groß ist da der Unterschied zum System x86? Die CPU stammt von Intel, die Speicher-Peripherie von z.B. EMC2 das Betriebs-System von Microsoft, die Datenbank häufig von Oracle, zusammengefügt wird das Ganze insbesondere von HP aber auch Dell und Lenovo.

Dem gegenüber steht die Lösungsphilosophie "der von einem Hersteller gelieferten integrierten Gesamt-Lösung", die in der IT-Welt seit jeher insbesondere von IBM vertreten wird mit "konzeptionellen Followern" wie in letzter Zeit insbesondere von Apple. Die zu beantwortende Schlüsselfrage bei der Entscheidung für die eine oder andere Alternative lautet insbesondere: Für welchen IT-Aufgabenbereich ist welche der beiden Alternativen die aus Unternehmenssicht bessere Wahl? Nach unserer langjährigen IT-Erfahrung und eindeutig bewiesen durch unser sehr umfangreiches IT-Datenmaterial: Für singuläre Aufgabenstellungen, wie sie häufig in Unternehmens-Abteilungen auftreten, ist es oft ein kleiner Computer mit nach Bedarf ausgewählter Funktionalität. Für die zentrale Unternehmens-Informationsverarbeitung dagegen, wo es entscheidend auch auf langfristige Homogenität und Migrationssicherheit ankommt, bietet die von einem Hersteller gelieferten integrierten Gesamt-Lösung i.d.R. das eindeutig bessere Preis/Leistungs-Verhältnis.

Produktivitäts-Vorteile durch umfangreiche "Productivityware", bei IBM erstaunlicherweise Middleware genannt

Da die Informationsverarbeitung von ihrem Wesen her insbesondere ein Werkzeug zur Produktivitäts-Steigerung in den Unternehmen ist, die nach unserem Datenmaterial etwa 80% des IT-Unternehmens-Nutzens ausmacht, Microsoft benennt übrigens "Productivity Services" als eine seiner "beiden Visionen des Unternehmens", ist die "Zielsetzung der Best-möglichen Produktivität auch im IT-Bereich eines Unternehmens" geradezu eine Selbstverständlichkeit. Da die reinen IT-Personalkosten in der deutschen Versicherungsbranche 2014 die erstaunliche Größe von 55,8% des IT-Budgets, unter Berücksichtigung der Anwendungs-SW sogar 58,5%, erreicht haben, nach nur etwa 20% Mitte der 70er Jahre, ist "das Angebot von Produktivitäts-Werkzeugen für den IT-Bereich" von entscheidender Bedeutung für das Preis/Leistungs-Verhältnis einer Computer-Architektur. Dabei dürfen die Kosten von Produktivitäts-Werkzeugen natürlich nur zusammen mit den Kosten der Profiteure der Werkzeuge, d.h. den dadurch produktiver gemachten IT-Mitarbeitern miteinander verglichen werden: Denn produktivere Werkzeuge, die aufgrund der ökonomischen Gesetzmäßigkeiten aufwendiger und damit teurer sein müssen, benötigen weniger Personalunterstützung und ergeben damit geringere Personalkosten. Verglichen werden dürfen deshalb nur die Gesamt-Kosten der gleichen Output-Einheiten, d.h. das Totale Preis/Leistungs-Verhältnis (TPP = Total Price/Performance). In aller Regel führt der Einsatz leistungsfähigerer Werkzeuge zu einem besseren Preis/Leistungs-Verhältnis.

Für den ökonomisch ausgebildeten Fachmann nicht überraschend dürfte deshalb unsere Daten-basierte Erkenntnis sein, dass der MF der IBM das mit großem Abstand bessere Angebot an Produktivitäts-Werkzeugen für die IT-MA anbietet. Ein wichtiger Grund sind sicher die Skalen-Vorteile des MF, da sich die Entwicklung hoch leistungsfähiger Produkte erst ab einer gewissen Anzahl und Größe profitabel gestalten lässt. Da der MF in der Praxis bisher i.d.R. 100 bis 500 Mal die kommerzielle Leistungsfähigkeit der in der Praxis eingesetzten Versionen der Alternative Unix- oder x86-Server aufweist, gibt es nur sehr wenige größere kommerzielle Unix- oder x86-Server für die die Entwicklung aufwendiger Produktivityware überhaupt funktional sinnvoll ist. Für die Herstellung von Productivityware benötigt man des Weiteren i.d.R. hochqualifizierte Fachleute mit langjähriger Berufserfahrung. Deshalb ist es nach unserer Erfahrung stringent, dass es für Unix- oder x86-Servern bisher nur viel einfachere Produktivitäts-Werkzeuge gibt. Das hat zur Konsequenz, dass der Personal-Aufwand zur Produktion der gleichen Menge an kommerziellem IT-Unternehmens-Nutzen bei den Unix- oder x86-Servern in der deutschen Versicherungs-Branche i.d.R. 2,1-2,7 Mal so hoch ist, wie beim MF!

Wieso konnte die IBM die Vorteile der überlegenden "großen Organisations-Einheit MF" seit ca. 20 Jahren nicht mehr überzeugend durchsetzen?

Weil die Verantwortlichen des "IBM Produkt-Segments MF" leider versagt haben! Das ist starker Tobak in der Tat! Der aber leider notwendig ist, um wachzurütteln. Und der Verfasser dieser Analyse dürfte dazu auch ausreichend legitimiert sein: Denn er war während seiner IBM Karriere ab Ende der 70'er Jahre sowohl 2 Jahre verantwortlich für das MF-Marketing in Deutschland als auch 2 Jahre bei IBM US MF-Marketing auf Assignment und hat dabei auch die MF-Entwicklung und -Herstellung in Poughkeepsie und Montpellier sehr gut kennengelernt. In diesem ganzen Umfeld fehlte das Know-how für holistisches Ökonomie bzw. Value-Added-basiertes Marketing des MF! Die einzige Marketing-Argumentation, die dieses Umfeld, insbesondere von Poughkeepsie befeuert, zustande gebracht hat, waren "Product-Excellence"-Elogen. Der Verfasser darf für sich in Anspruch nehmen, dass er leider anscheinend einer der Wenigen war, die die Befähigung aufwiesen und anscheinend der Einzige war, der auch versucht hat, den Wert des MF v.a. auch als Produzent von Unternehmens-Nutzen darzustellen und das mit einigen Erfolgen zustande gebracht hat. Bemerkenswert ist in dieser Situation des Weiteren, dass zahlreiche IBM MF-Fachleute unsere Erkenntnisse voll bestätigt und ausgesprochen begrüßt haben: Ihnen hat insbesondere auch unser in ca. 30 Jahren zusammengetragenes Datenmaterial gefehlt, um ihre Einzel-Erkenntnisse zu einer fundierten Argumentation zu bündeln.Eine sehr große Herausforderung beim Wettbewerb von "Groß-Lösungen" gegen "Klein-Lösungen" ist die Definition eines "gemeinsamen, relevanten Leistungs- oder Nutzen-Maßstabes": Bei den angeblich "pragmatischen Schnellschuss-Ansätzen", die insbesondere im Angelsächsischen Kulturkreis sehr beliebt sind, werden da immer die Groß-Lösungen benachteiligt, denn zu deren Beurteilung benötigt man i.d.R. umfangreiches Datenmaterial und professionellen Durchblick.

Wir wollen diese Herausforderung an folgender Aufgabenstellung beispielhaft darstellen: "Reise nach Berlin", von München aus, 600 Km. Welches ist das beste Transportmittel? Das Flugzeug? Die Bahn? Das Auto? Oder gar das billige Fahrrad? Natürlich weiß eigentlich jeder Deutsche aus Erfahrung sofort die Antwort: Natürlich nicht das Fahrrad: Weil man da 3-4 Tage unterwegs wäre. Das Fahrrad kostet, geliehen, wahrscheinlich nur ca. € 100. Aber die Personalkosten mit Übernachtungen dürften bei einer Dienstreise etwa € 2.500 betragen. Holistischer ökonomischer Maßstab: "Totales Preis/Leistungs-Verhältnis 4,33 €/Km!" mit weiteren Unwägbarkeiten. Beim Auto kostet der "Passagier-Km" etwa 0,47 €/Km (Gesamt-Kosten für den durchschnittlichen deutschen PKW 0,80 €/Km und einem Sitzlade-Faktor = 1,7 laut ADAC), bei der Bahn ca. 0,10 €/Km und beim Flugzeug 0,04 €/Km (LH Werbung). Dabei kostet ein Airbus A320 ca. 85 Mio €(Listenpreis). Dazu kommen noch Start- und Lande-Gebühren und Kosten für den Betrieb, Wartung, Abschreibung, usw.: Und trotzdem bietet dieses scheinbar wahnsinnig teure Transportmittel das beste, für den Reiseinteressenten besonders wichtige holistische Preis/Leistungs-Verhältnis, d.h. Preis pro Transport-Kilometer. Anmerkung: Für die Transportmittel Auto, Bahn und Flugzeug haben wir auf die Einbeziehung der Personalkosten verzichtet, da die Zeit für den Transport inklusive Anreise- und Abreise zu Bahnhof oder Flughafen in etwa vergleichbar sein dürfte. Das in der Anschaffung mit großen Abstand teuerste Transportmittel Flugzeug ist, bei geeigneter Transportaufgabe und professioneller Realisierung, die "Groß-Lösung" mit dem besten holistischen Preis/Leistungs-Verhältnis, während das Fahrrad eine "Klein-Lösung" darstellt, für die es natürlich auch viele best-geeignete Aufgaben gibt. Es gibt viele solche Groß- vs Klein-Lösungskonstellationen, aus denen sich die ökonomische Basisgesetzmäßigkeiten erlernen lassen! Da könnten die für das MF-Marketing Verantwortlichen in die Lehre gehen.

Da es die MF-Marketing-Verantwortlichen der IBM in den letzten 20 Jahren nicht fertig gebracht haben, das Marketing von den scheinbar so unschlagbar billigen "Klein-Lösungs-Anbietern: Unix- und x86-Server" als Hype zu entlarven, haben wir uns entschlossen, noch einmal "in den Ring zu steigen", um dem MF seinen rechtmäßigen Platz in der Unternehmens-Informationsverarbeitung zurückzugeben. Darüber hinaus lässt sich die gegenwärtige "Losers-only"-Situation zu einer "Winners-only"-Situation weiter entwickeln mit den in der (Einführung) offen gelegten Potentialen, die alle zufrieden machen dürften.

Bedeutung des MF für die Unternehmens-IT der dt. VB in Kennzahlen

Während das "Private Computing", repräsentiert v.a. durch Apple, Google, Facebook, Twitter, Microsoft, hervorragendes Wachstum aufweist, ist das "Unternehmens-Computing" (UIT) in den letzten ca. 10-15 Jahren in eine Art Identitätskrise hineingeschlittert, die auf die ausstehende Beantwortung von vor allem 2 Schlüsselfragen der Unternehmen-IT zurückgeführt werden kann: Die erste und wichtigste Frage lautet: "Was ist der ‚Best Practice Wertbeitrag' der Unternehmens-IT?" Und die zweite unbeantwortete Fragestellung, deren Nichtbeantwortung die Entwicklung der Unternehmens-IT immer nachhaltiger verlangsamt hat, lautet: "Was ist die ‚Best Practice Verteilung' der gesamten Unternehmens-IT-Arbeitslast auf die bis zu 4 Computer-Architekturen der Gegenwart?" Die nachfolgenden, "Data-Mining-basierten Erkenntnisse zur Realisierung der Unternehmen-IT auf Best-Practice-Niveau" beantworten die zweite Fragestellung, bei der die Entwicklung offensichtlich an einer entscheidenden Weichenstellung angekommen zu sein scheint, die da lautet: Wird die zukünftige Entwicklung der UIT geprägt sein durch ein Computer-Architektur-Duopol, bei dem die "Kommerzielle Arbeitslast" auf dem MF und die "Abteilungs-spezielle sowie die wissenschaftlich- und zunehmend auch lexikalisch-geprägte Arbeitslast" auf spezialisierten Computern, wie den "Unix-Servern" und den "x-86-Servern" verarbeitet wird? Oder sollte die gesamte Unternehmens-Arbeitslast aus Kosten-, Ausbildungs- und Homogenitäts-Gründen nur auf einer Computer-Architektur zur Ausführung gebracht werden, nämlich der nach weit verbreiteter Meinung, die aber wissenschaftlich nicht erwiesen ist, scheinbar sehr preiswerten x-86-Architektur?

In dieser Analyse der UIT der deutschen Versicherungsbranche werden wir die Ergebnisse der Auswertung unseres sehr umfangreichen Datenmaterials zur Thematik "Best Practice Verteilung der Unternehmens-IT-Arbeitslast" im Einzelnen darstellen und erklären, wie wir zu den Erkenntnissen gekommen sind, die in der Überschrift zusammengefasst sind. Diese Erkenntnisse kann sich im Übrigen auch jeder selbst erarbeiten, so er denn über das benötigte Datenmaterial und die notwendigen Sachkenntnisse für eine professionelle Auswertung verfügt.

Zur Positionierung der Bedeutung dieser Thematik erscheinen uns die folgenden IT-Kennzahlen der deutschen Versicherungsbranche mit Status 2014 gut geeignet zu sein:

| 1. | Gesamte Unternehmens-Nutzen produzierende Computer-Arbeitslast der dt. Versicherungs-Branche 2014: | 622,6 GIPS | |

| → davon MF | 306,8 GIPS | = 49,3% | |

| → Anzahl MF | 58 Systeme | ||

| 2. | Summe aller IT-Budgets der dt. VB 2014 (incl. DWh ~6%) | 2.944,1 Mio | |

| → davon MF | 986,5 Mio | = 35,7% | |

| 2.1 | Kosten der HW | 231,9 Mio | = 8,38% |

| davon MF | 139,2 Mio | = 5,03% | |

| 2.2 | Kosten der SSW | 381,1 Mio | = 13,8% |

| → davon MF | 225,4 Mio | = 8,15% | |

| 2.3 | Personal-Kosten | 1.619,7 Mio | = 58,5% |

| → davon MF | 494,9 Mio | = 17,9% | |

| 2.4 | Betriebs-Kosten | 443,2 Mio | = 15,1% |

| → davon MF | 126,6 Mio | = 4,30% | |

| 3. | Anzahl aller IT-MA | 16.880 | = 100% |

| → davon MF | 3.039 | = 18,0% | |

- Der MF hat bereits im Branchendurchschnitt das beste Preis/Leistungs-Verhältnis: Der Unternehmens-Nutzen-Beitrag von 49,3% kostet nur 33,5% der IT-Budgets. Noch viel interessanter und bedeutender sind natürlich die "Best-Practice"-Erkenntnisse, die wir aus unserem Datenmaterial ebenfalls herausfiltern und den einzelnen VU zur Verfügung stellen können.

- Der Hauptgrund für die Überlegenheit des MF liegt in den mit Abstand niedrigsten IT-Personal-Kosten pro IT-Unternehmens-Nutzen-Einheit von nur 17,9% gegenüber dem Branchendurchschnitt von 58,5%!

- Diese niedrigen IT-Personal-Kosten des MF sind das Ergebnis einer sehr leistungsfähigen "Productivityware", die die IBM insbesondere ab 2002 den MF-Kunden zur Verfügung stellen konnte!

- Des Weiteren deckt schon diese Version der IT-Kennzahlen auf, dass die Behauptung, die System-SW des MF sei unverhältnismäßig teuer, ebenfalls auf einem unzulässigen Vergleich zu basieren scheint. Denn der MF hat schon bei dieser, den IT-Unternehmens-Nutzen-Beitrag des MF noch nicht berücksichtigenden Version das eindeutig beste Preis/Leistungs-Verhältnis auch im Bereich der SSW: 8,15% vs 13,8%!

Realisierung der Erkenntnisse vom überlegenen Preis/Leistungs-Verhältnis des MF in den Unternehmen in der dt. VB auf "Best-Practice-Niveau"

Zu beantworten sind an dieser Stelle der Analyse noch die folgenden 2 Fragestellungen: Bis zu welchem Anteil der Unternehmens-Arbeitslast hat der MF das Beste Preis/Leistungs-Verhältnis? Und was ist das "Best-Practice-Niveau" der Verarbeitung auf dem MF? Dabei wollen wir zur Absicherung der Erkenntnisse für den MF natürlich auch die entsprechenden Daten der 3 konkurrierenden alternativen Computer-Architekturen "Unix-Server", "x86-Server" und "Client/Server + PC" offengelegen.

Mit diesen Zielsetzungen haben wir die Daten der gegenwärtig 61 selbständigen IT-Bereiche der dt. VB ausgewertet, die wir seit 26 Jahren, Jahr für Jahr, von unserer ausgezeichnet qualifizierten "Kollaborativen Community" zur Verfügung gestellt bekommen. Flankiert und Plausibilitäts-geprüft werden die IT-Erkenntnisse durch unsere Auswertungen der jährlichen Geschäftsberichte der analysierten Unternehmen sowie der Hersteller der Produkte der 4 Computer-Architekturen.

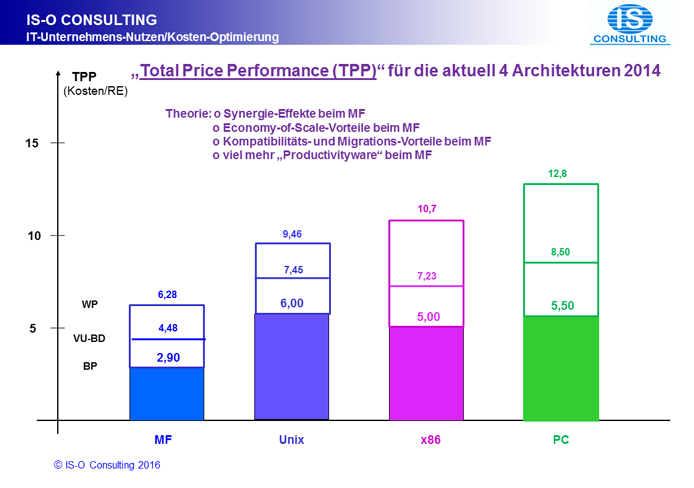

Best-Practice-Niveau des MF in der dt. VBZum besseren Verständnis und zur Controlling-Befähigung wollen wir mit der Übersicht über das "Totale Preis/Leistungs-Verhältnis (englisch TPP)" der 4 Computer-Architekturen beginnen, die in (Abbildung 1) zusammengestellt ist. Sie zeigt die 3 Realisierungs-Niveaus "Best-Practice (BP)", "Versicherungs-Unternehmen im Branchen-Durchschnitt (VU-BD)" und "Worst-Practice (WP)", Unternehmen, die es aufgrund der auch in der dt. VB wirkenden ökonomischen Gesetze natürlich auch geben muss: Gauss'sche Verteilung. Die betroffenen Verantwortlichen wollen das verständlicherweise eher ungern wahrhaben: Dabei haben gerade diese Unternehmen den größten ökonomischen Unternehmens-Nutzen von diesen Erkenntnissen!

gegenwärtig bis zu 4 Computer Architekturen der deutschen Versicherungs-Branche (Status 2014)

Diese Auswertung zeigt die folgende Grunderkenntnis:

- Der MF ist allen anderen Computer-Architekturen eindeutig überlegen, und zwar um mindestens Faktor 1,7!

Größe des Unternehmens-Arbeitslast-Anteils mit dem "Besten Preis/Leistungs-Verhältnis des MF" in der dt. VB

Der MF ist bekanntlich für die Verarbeitung "kommerzieller Arbeitslast" bei der Aufgabenstellung "Enterprise Computing" optimiert: Diese Optimierung umfasst sowohl die HW-Ebene als auch die Ebene des Betriebssystems und insbesondere die Ebene der Middleware, die v.a. "Productivityware" ist und deshalb sehr hohen Einfluss hat auf die benötigte Anzahl IT-Mitarbeiter! Die besondere konzeptionelle Herausforderung beim Enterprise Computing besteht darin, dass es aus einem tief gestaffelten, hoch komplexen Multiprogramming mit sehr vielen Hauptspeicher-Zugriffen und sehr umfangreichen Ein/Ausgabe-Vorgängen besteht und den Betrieb einer sehr umfangreichen Peripherie aus Daten-Speichern und Daten-Archiven, Druckstraßen, TP-Netzen und dieses alles mit Katastrophen-Absicherung umfasst. Aus der Konstellation, dass bei IBM die MF-Systeme und die p-Systeme, die für "wissenschaftliche Arbeitslast" optimiert sind, die gleiche HW-Basis haben, ist bereits mit großer Eindeutigkeit abzuleiten, dass die Computer-Architektur-Fachleute der IBM davon überzeugt sind, dass die MF-Architektur i.d.R. die bessere TPP für kommerzielle Unternehmens Arbeitslast hat: Anderenfalls wäre die Differenzierung zwischen MF und p-Systemen ökonomischer Unsinn. Die x86-Systeme, deren "Ahnherr" bekanntlich der PC ist, also eine "Architektur für Mono-Processing mit trivialer Peripherie-Ausstattung", erscheinen uns eher wie ein Zwitter zwischen PC und MF: Sie wurden aus verständlichen Herstellerinteressen seit den 90'er Jahren immer stärker in Richtung Enterprise-Computing weiter entwickelt, sind nach unserem Erkenntnisstand aber erst auf einem Niveau von "Möchtegern-MFs" angelangt. Uns erinnert das an den bis in die 80'er Jahre im T/W-Bereich sehr erfolgreich Prozess-Systeme-Hersteller DEC, der mit einer neuen Wachstums-Strategie versuchte, auch in den kommerziellen RZ seiner Kunden Fuß zu fassen, indem er den den hervorragenden T/W-Systemen MF-Aufgaben aufoktroyierte: Das Ergebnis ist bekannt.

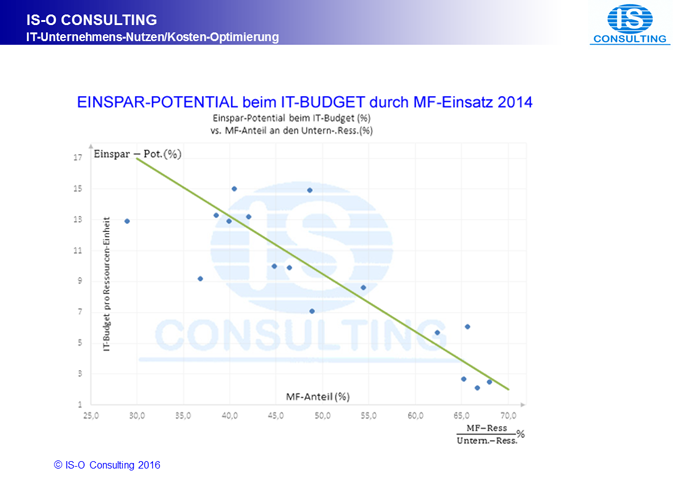

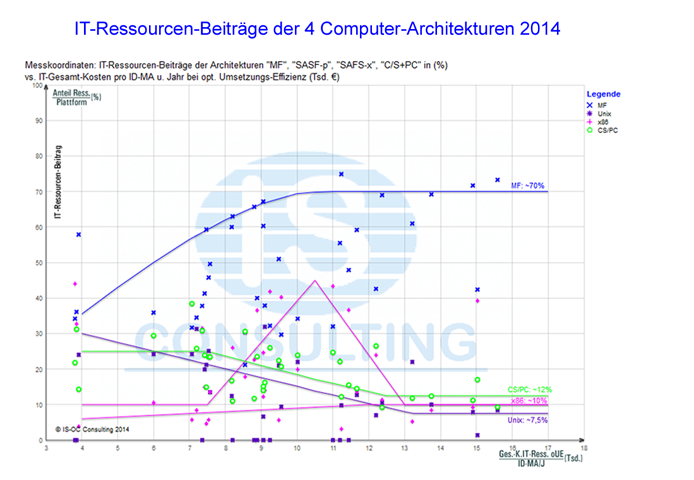

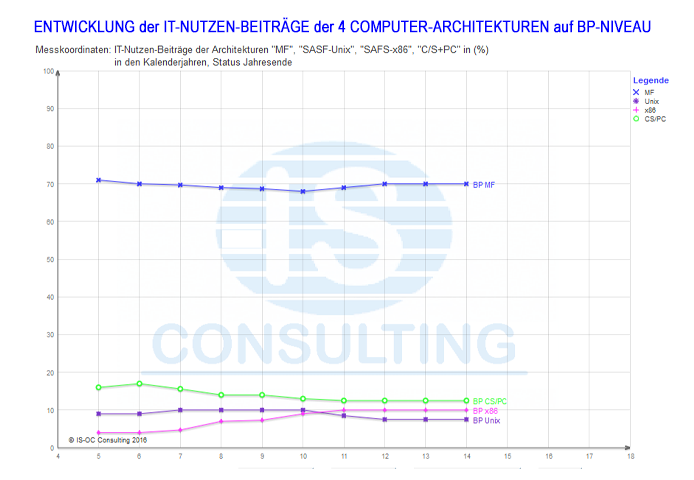

Da in unserem IT-Datenmaterial, das wir über einen Zeitraum von 26 Jahren, Jahr für Jahr, von im Durchschnitt ca. 61 IT-Bereichen zusammengetragen haben und das v.a. von unserer hoch kompetenten Kollaborativen Community stammt, de facto alle Computer-Architektur-Kombinationen mit ihrer Entwicklung in diesem Zeitraum vertreten sind, können wir die Frage nach dem "Unternehmens-Arbeitslast-Anteil bei dem der MF das Beste Gesamte Preis/Leistungs-Verhältnis (TPP)" aufweist, ziemlich eindeutig beantworten (Abbildung 2) und (Abbildung 3):

bis zu 4 Computer Architekturen in der deutschen Versicherungs-Branche (Status 2014)

auf BP-Niveau” in der deutschen Versicherungs-Branche (Status 2014)

- Der MF hatte 2014 bei mindestens 70% der Unternehmens-Arbeitslast das Beste TPP.

Für Theorie-geprägte IT-Fachleute sei angefügt, dass die Qualität der Erkenntnisse unseres Lösungsansatzes zur Bestimmung der MF-AL mit dem BP-TPP theoretisch weiter verbessert werden könnte durch "Benchmarking einer repräsentativen Arbeitslast eines VU" durch ein Fachunternehmen, wie z.B. TPC oder auch IBM. Das wäre vergleichbar mit den Benchmarks der IBM für jede neue Generation von MFs oder mit den BM der IBM von p-Servern und früher x86-Servern bei TPC. Da bei diesem Ansatz die Herausforderung in der Bestimmung einer "repräsentativen Arbeitslast für ein VU" liegen dürfte, ist nach unserem gegenwärtigen Erkenntnisstand offen, ob dieser Ansatz tatsächlich höherwertige Ergebnisse zur Verfügung stellen würde.

Einspar-Potential für ein einzelnes Versicherungs-Unternehmen und Geschäfts-Potential durch Einsatz des MF auf Best-Practice-Niveau: Eine Winners-only-Lösung!

Bei einer "Nicht-Best-Practice-Verteilung der Unternehmens-Arbeitslast" auf die gegenwärtig bis zu 4 Computer-Architekturen handelt es sich um eine Aufgabestellung der "Ineffizienz-Beseitigung", die in "Winners-only-Vorgehensweise" gelöst werden kann. Zur Veranschaulichung: Das scheint uns gut vergleichbar zu sein mit der Situation bei einem Automobil mit schlecht eingestelltem Motor, wo ein Werkstattbesuch sowohl dem Besitzer des Autos als auch dem Eigentümer der Werkstatt einen Gewinn verschafft.

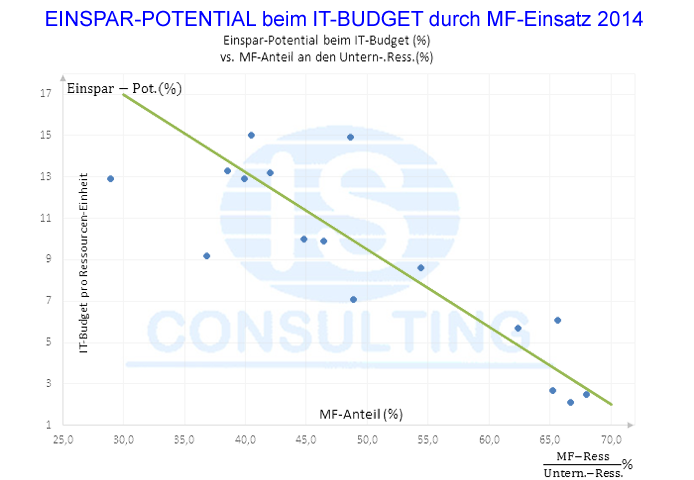

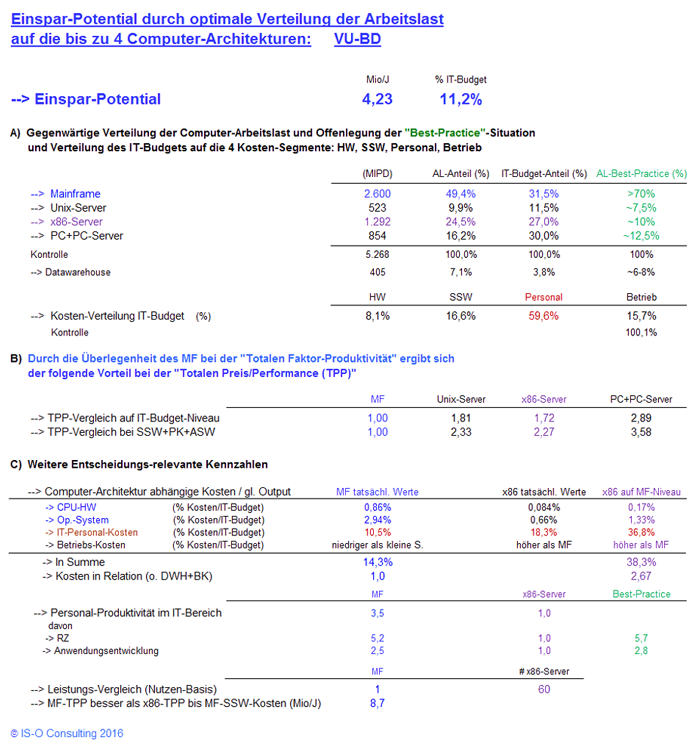

Das Einspar-Potential für die Kunden und das zusätzliche Geschäfts-Potential für den MF-Anbieter lässt sich für die dt. Versicherungsbranche auch in einem Diagramm darstellen: Die Auswertung in (Abbildung 4) zeigt, dass die Potentiale für beide Seiten, VU wie MF-Anbieter, von bemerkenswerter Größe sind: Für die VU können sie bis zu 15% des IT-Budgets und für den MF-Anbieter bis zu 130% der Investitionen in den MF betragen!

in Abhängigkeit vom "Anteil der auf dem MF produzierten Unternehmens-Arbeitslast in (%)" (Status 2014)

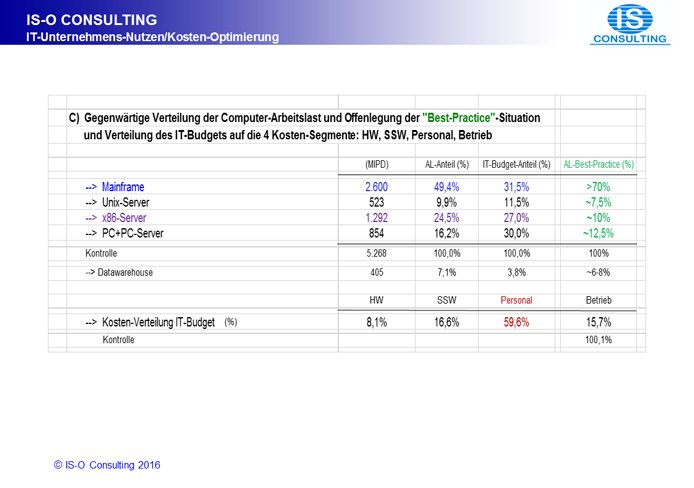

Die Potential-Situation eines einzelnen Versicherungs-Unternehmens (VU) wird durch die gegenwärtige Verteilung der IT-Arbeitslast auf die bis zu 4 Computer-Architekturen und deren Realisierungs-Effizienz definiert.

- Beim "statistischen deutschen VU" sah diese Verteilung 2014 wie folgt aus:

MF: 49,3%, Unix-Server (ohne DWh): 9,9%, x86-Server: 24,4%, PC: 16,4%. - Die "Best-Practice-Verteilung" war 2014 in etwa wie folgt:

MF: 70%, Unix-Server (ohne DWh): 7,5%, x86-Server: 10,0%, PC: 12,5%.

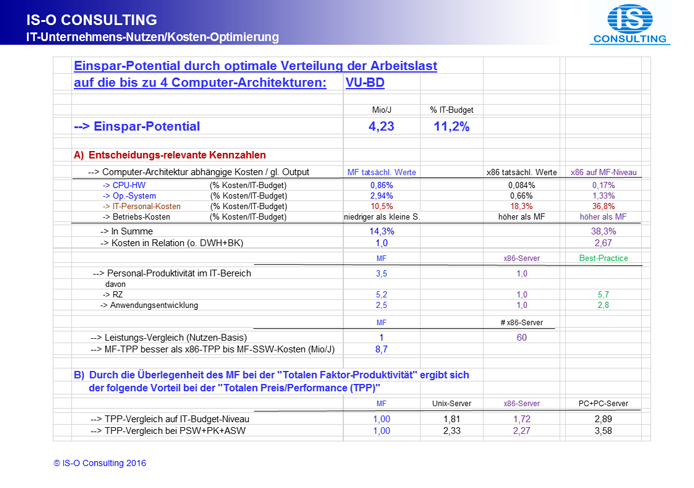

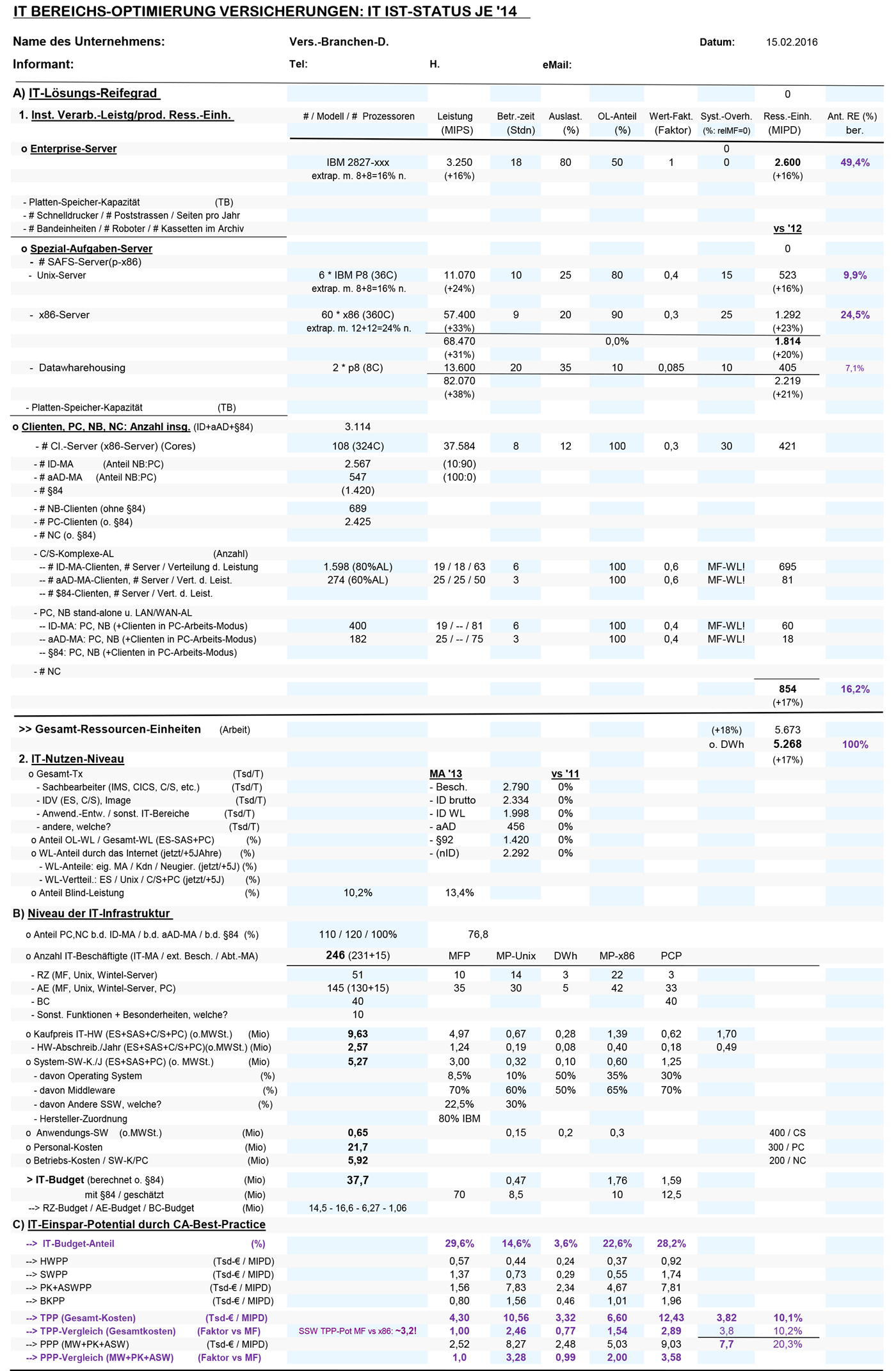

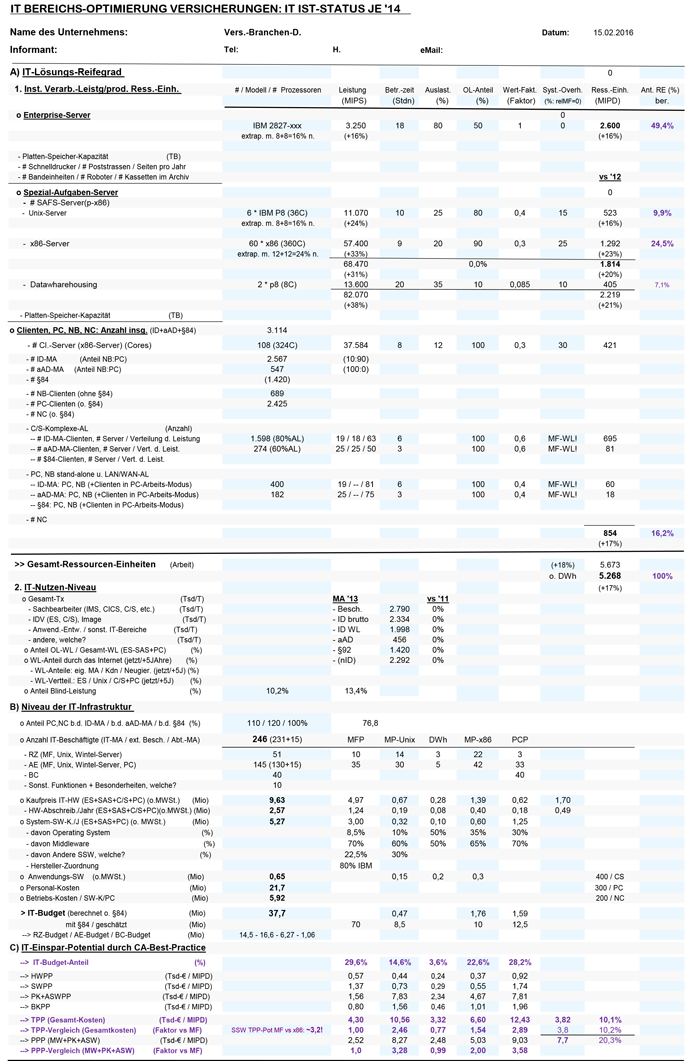

Für eine "kompakte Übersicht über die repräsentativen IT-Daten eines dt. VU" haben wir die in (Abbildung 5) dargestellte Tabelle entwickelt. Diese wird von uns und unserer Kollaborativen Community jährlich auf den Status Jahresende aktualisiert. Selbstverständlich wird die Auslegung der Tabelle den auftretenden IT-Weiterentwicklungen auch zeitnah angepasst.

(Die eingetragenen Daten sind repräsentativ für ein VU mit den statistischen Durchschnitt der dt. VB (Status 2014))

(Die eingetragenen Daten sind repräsentativ für ein VU mit den statistischen Durchschnitt der dt. VB (Status 2014))

Ansicht vergrößern

In dieser Übersicht sind in "Teil C): IT-Einspar-Potential durch CA-Best-Practice" das Nutzen-Potential für den IT-Bereich des Versicherungsunternehmens skizziert als Einstieg in eine Realisierungs-Aktion. Bei unserem Ansatz lassen sich das "IT-Budget-Einspar-Potential" und das "zusätzliche Geschäfts-Potential für den MF-Anbieter" anhand der "Best-Practice-Verteilung" de facto "auf einem Bierdeckel" skizzieren.

Für ein "einzelnes Versicherungs-Unternehmen" können die dafür Verantwortlichen durch Eingeben eines VU-individuellen Passwortes, das per eMail unter der Adresse IS-OC@aol.com beantragbar ist, diese Excel-Tabelle mit ihren Auswerte-Algorithmen aufrufen und ihre Unternehmens-IT-Daten eingeben. Um diese Daten für eine weitere Bearbeitung zur Verfügung stellen zu können, werden sie in unserer Cloud gespeichert.

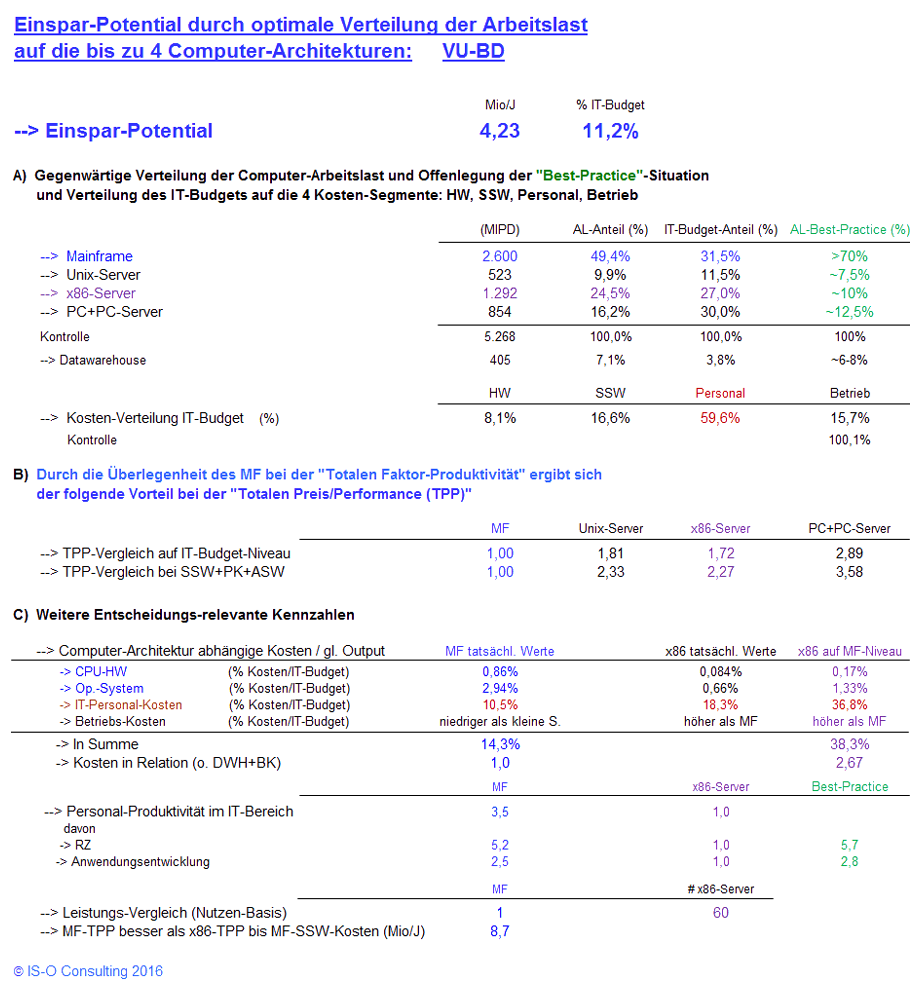

Vergleich der beiden wichtigsten Computer-Architektur-Alternativen der Gegenwart "MF" und "x86-Server" auf einem "dynamischen Bierdeckel"

Auf Wunsch unserer Kollaborativen Community haben wir die wichtigsten "Kennzahlen für die Nutzen-Potential-Realisierung" mit kurzen Erläuterungen in einer weiteren Excel-Tabelle zusammengefasst (Abbildung 6). Dabei haben wir auch die Ergebnisse eines Vergleichs der Hauptkonkurrenten "MF" und "x86-Server" in den "Lösungs-Segmenten" mit den größten Kosten-Unterschieden, d.h., "CPU-HW", "Operating System" und "benötigtes IT-Personal" offen gelegt. Da wir für das Kosten-Segment "Betriebs-Kosten" keine belastbaren, detaillierten Daten einsammeln konnten, haben wir dieses Segment nicht berücksichtigt. Natürlich ist uns bekannt, dass viele Untersuchungen, auch von IBM, zu dem Ergebnis kamen, dass in diesem Segment der MF die wesentlich niedrigeren Kosten aufweist.

(Die eingetragenen Daten sind repräsentativ für ein VU mit den

statistischen Durchschnitt der dt. VB (Status 2014))

(Die eingetragenen Daten sind repräsentativ für ein VU mit den

statistischen Durchschnitt der dt. VB (Status 2014))

Ansicht vergrößern

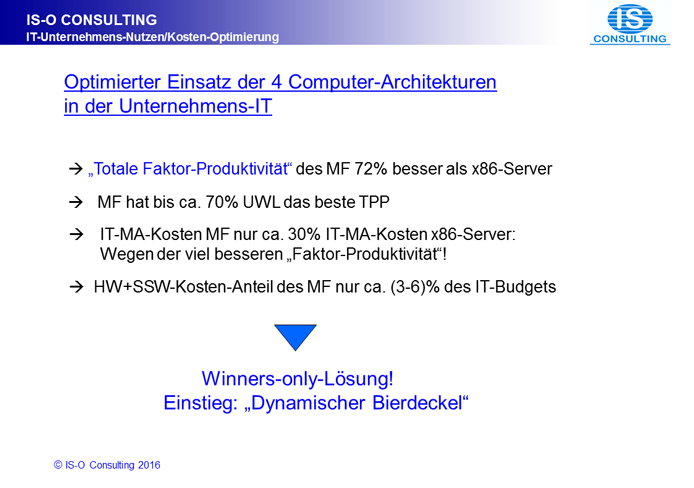

Um der erstaunlich wirksamen "Post-Data Marketing-Propaganda" der Wettbewerber des MF nach inzwischen ca. 20 Jahren endlich Paroli zu bieten und die offensichtliche Hilflosigkeit der verantwortlichen IBM MF-Marketing-Funktionen zu kompensieren, wollen wir versuchen, die ökonomischen und organisatorischen Vorteile des "Mainframe" gegenüber dem gegenwärtigen Haupt-Konkurrenten "x86-Server" zunächst quasi "auf einem dynamischen Bierdeckel" darzustellen. Unsere durch Data- und Decision-Mining gewonnenen Erkenntnisse lassen sich wie folgt zusammenfassen.

Zusammenfassung

- Die MFs produzierten in der dt. VB im Branchendurchschnitt 2014 49,4% des Unternehmens-Nutzens und benötigten dazu nur 31,5% des IT-Budgets.

- Die x86-Server produzierten in der dt. VB im Branchendurchschnitt 2014 24,5% des Unternehmens-Nutzens und benötigten dazu 27,0% des IT-Budgets.

- Daraus folgt: Der MF hat schon im Branchen-Durchschnitt ein 72,5% besseres TPP als die x86-Server.

- Bei Vergleich auf jeweils Best-Practice-Niveau beträgt der Vorteil des MF 72% TPP!

- Um die wesentlichen Ursachen der Überlegenheit des MF herauszufinden, muss das holistische Ergebnis von 72% differenziert werden in seine Einzelkomponenten: Dabei offenbart sich die Einzelkomponente "Productivity-SW-Kosten + Personal-Kosten + Anwendungsentwicklungs-SW-Kosten" als Hauptverursacher der Überlegenheit mit

- TPP-Vorteil des MF vs x86-Server" um Faktor 2,27

- Und TPP-Vorteil des MF im Bereich der Personal-Kosten um Faktor 3,5

- Dieser holistische Entscheidungs-Ansatz liefert auch die fundamentale Erkenntnis, dass eine "Gegenüberstellung der Einzelkomponenten der Informationsverarbeitung", also der "System-HW-Investitionen", der "System-SW-Investitionen", der "IT-Mitarbeiter-Personal-Kosten" und der "IT-Betriebs-Kosten" zu grundsätzlich falschen Aussagen führt! Denn die Unternehmens-Informationsverarbeitung ist als "Produktionsanlage für die von einem Unternehmen benötigten Informationen der Mitarbeiter und Kunden" zu verstehen: Sie muss zum einen von Zeit zu Zeit in ihrer Leistungsfähigkeit in diskreten Schritten ausgebaut werden, um die benötigten zusätzlichen Unternehmens-Informationen produzieren zu können. In sie muss aber zum anderen auch systematisch in die IT-Produktionsmittel zur Realisierung der Best-Practice-Produktivität investiert werden, um die zusätzlich benötigte Leistungsfähigkeit möglichst mit der gleichen Anzahl IT-Mitarbeiter bewältigen zu können.

Einzelheiten

- Kosten der System-HW für die Verarbeitung der Unternehmens-Anwendungen:

(Durchschnittswerte der dt. Versicherungsbranche)

- MF-Server-Kosten pro Jahr: 5,1% des IT-Budgets.

- x86-Server-Kosten pro Jahr: 2,06% des IT-Budgets.

Erläuterung zur System-HW:- Die Bezeichnung Mainframe steht nur für die CPU eines "MF-Servers".

- Der Kosten-Anteil der MF-CPUs betrug 2014 nur 1,13% des IT-Budgets.

- Der Kosten-Anteil der x86-CPUs betrug 2014 0,14% des IT-Budgets.

- Die System-Peripherie, die für die "Unternehmens-Anwendungen" benötigt wird, ist in ihrer Größe und damit auch in ihrem Wert de facto unabhängig von der Architektur der CPUs, wahrscheinlich mit Vorteilen für den MF. Der Kosten-Anteil der Peripherie für die Unternehmens-Anwendungen beträgt i.d.R. 3,5-5,0% des IT-Budgets.

- Kosten der System-SW für die Verarbeitung der Unternehmens-Anwendungen:

(Durchschnittswerte der dt. Versicherungsbranche)

- MF-System-SW-Kosten pro Jahr: 8,21% des IT-Budgets, davon sind

- Betriebs-System-Kosten pro Jahr: 0,70% des IT-Budgets

- Middleware- oder "Produktivityware-"Kosten pro Jahr: 5,75% des IT-Budgets, die bei Vergleichen mit den IT-Personal-Kosten bilanziert werden müssen!

- Andere SW-Kosten pro Jahr: 1,85% des IT-Budgets,

- x86-System-SW-Kosten pro Jahr: 2,72% des IT-Budgets, davon sind

- Betriebs-System-Kosten pro Jahr: 0,96% des IT-Budgets und

- "Produktivityware"-Kosten pro Jahr: 1,79% des IT-Budgets, die bei Vergleichen natürlich ebenfalls mit den IT-Personal-Kosten bilanziert werden müssen!

Erläuterung zur System-SW:- Die Bezeichnung "System-SW" ist ein Oberbegriff, der v.a. das "Betriebssystem", die "Produktivityware", bei IBM Middleware genannt, und weitere System-Steuer-SW umfasst.

- Beim MF setzten sich die "System-SW-Kosten" wie folgt zusammen: "Betriebs-SW" ca. 8,5%, "Productivityware" ca. 70%, "Andere SW" ca. 22,5%

- Bei den x86-Systemen lassen sich die "System-SW-Kosten" nach unserem gegenwärtigen Datenmaterial in "Betriebs-SW" ca. 35% und "Productivityware" ca. 65% unterteilen. Dabei fällt sofort auf, dass die Kosten für die "Productivityware" insbesondere in Relation zum Output der x86-Systeme sehr niedrig sind, was eindeutig auf nur geringe Funktionalität und damit auf niedrige Produktivitäts-Beiträge schließen lässt!

- Die Funktionalität und damit die Produktivitäts-Beiträge von "Productivityware" sind theoretisch unabhängig von der Architektur von Computern! Wenn eine bestimmte "Productivityware" nur wenig kostet, dann ist das ein untrüglicher Indikator dafür, dass dieses Produkt nur über eine geringe Funktionalität verfügen dürfte und sein Einsatz deshalb zu höheren Personal-Kosten führen wird. Andererseits lassen hohe "Productivityware"-Kosten Rückschlüsse auf eine wahrscheinlich reichhaltige Funktionalität zu. Eine objektive Entscheidung ist aber erst in Kombination mit den jeweils notwendigen IT-Personal-Kosten möglich.

- Die wesentlich geringere Ausstattung der x86-Systeme mit "Productivityware" in der dt. VB hat wahrscheinlich 2 Gründe: Zum einen ein zu schlechtes Preis/Leistungs-Verhältnis beim Einsatz auf spezialisierten Abteilungs-Servern. Und in der Ausgangslage, ökonomisch leicht erklärbar, ein wesentlich geringeres Angebot wegen der viel geringeren Anzahl an x86-Systemen eingesetzt für Unternehmens-Informationsverarbeitung. Nach unseren Recherchen dürfte ihre Anzahl bei eindeutig weniger als 10% der Anzahl der MF angesiedelt sein.

- MF-System-SW-Kosten pro Jahr: 8,21% des IT-Budgets, davon sind

- IT-Personal-Kosten für die Verarbeitung der Unternehmens-Anwendungen:

(Durchschnittswerte der dt. Versicherungsbranche)

- PK zur Produktion auf dem MF: 10,9% des IT-Budgets bei 49,3% der Unternehmens-Arbeitslast eines dt. VU.

- PK zur Produktion auf den x86-Servern: 18,3% des IT-Budgets bei 24,5% der Unternehmens-Arbeitslast eines dt. VU. Vor einem Vergleich muss die AL der x86-Server auf das Niveau der MFs gebracht werden, d.h. um den Faktor 49,3/24,5 erhöht werden. Auf MF-Niveau würde die AL der x86-Server somit 36,8% des IT-Budgets kosten.

- Diese Situation bilanziert ergibt die Erkenntnis, dass die Produktivität der Verarbeitung der Unternehmens-Anwendungen auf den MF um den Faktor 3,5 oder 250% besser ist als auf den x86-Systemen.

- Bei dieser Korrelation ist unterstellt, dass die Produktivität auf den x86-Systemen auch bei der Produktion von Unternehmens-Anwendungen die gegenwärtige, nur für Abteilungs-Anwendungen, gemessene Produktivität erreichen könnte: Eine Annahme, die sehr wahrscheinlich wesentlich zu optimistisch sein dürfte.

- Betriebs-Kosten bei der Produktion der Unternehmens-Anwendungen

Die Semantik der Bezeichnung "IT-Betriebs-Kosten" ist in ihrer Definition und Abgrenzung eher schwammig: Dazu gehören natürlich v.a. die jährlichen Kosten für RZ- und Büroflächen, für Stromversorgung und Kühlung, die Kommunikations-Kosten, die Material-Kosten, Reise-Kosten. In der deutschen Versicherungs-Branche sind das üblicherweise ca. 14,5% des IT-Budgets, über die letzten Jahre relativ unverändert bis leicht fallend.

Natürlich ist uns bekannt, dass vor 10-5 Jahren zahlreiche Situations- und Erfahrungs-Berichte publiziert worden sind, bei denen über erhebliche Einsparungen im Bereich der Betriebs-Kosten durch "Konsolidierung von Server-Farmen auf MFs" berichtet worden ist. Für den "Nachweis der Überlegenheit des Mainframe für kommerzielle Unternehmens-Anwendungen insbesondere beim Vergleich mit den x86-Servern" erscheinen uns diese holistisch betrachtet eher marginalen Vorteile zunächst vernachlässigbar zu sein.

Unterstützung durch IS-O Consulting

Da wir unser IS Consulting seit 2002 immer stärker über das Internet realisiert haben und viele Daten nach heutigem "Sprech" in der Cloud gespeichert sind, erfolgt unser Consulting fast ausschließlich über das Internet. Dabei bieten wir 2 Consulting-Alternativen an:

- Eine "Kurz-Analyse-Version" mit der Zielsetzung, unseren Methodischen Ansatz zu erläutern und zunächst die Frage zu klären, ob ein Einsatz gewinnbringend wäre und die Erkenntnisse auch realisiert werden könnten. Für das dafür benötigte Datenmaterial genügt die Genauigkeit "Pi-mal-Daumen". Diese Version ist kostenlos.

- Wenn die Kurz-Analyse-Version zu einem positiven Ergebnis führt und dieses IT-Einspar-Potential auch tatsächlich realisiert werden soll, dann bieten wir als Basis dafür eine "Anleitung zur Realisierung" basierend auf dann von uns erarbeiteten "Qualitäts- und Plausibilitäts-geprüftem Datenmaterial". Die Vergütung kann entweder über einen Festbetrag erfolgen oder über einen Anteil des realisierten IT-Nutzen-Potentials.

- Zur Verfügung stellen werden wir auch jeweils eine "jährliche Aktualisierung":

- Für die kostenlose Version ein kostenloses Update im Rahmen einer Mitgliedschaft in der von uns gecoachten "Kollaborativen Community".

- Für die Festpreis-Vergütungs-Version im Rahmen einer Aufwands-Vergütung. Bei der IT-Nutzen-Anteils-Vergütung ist die Aktualisierung in der Vergütung natürlich enthalten.

Einordnung dieses Themas in das IS-OC Consulting Know-how-Portfolio und die Bedeutung für die IT-Branche

Die "Vision von IS-O Consulting war und ist die Verfügbarmachung von Entscheidungs-Erkenntnissen zur Realisierung des IT-Unternehmens-Nutzens auf Best-Practice-Niveau durch Data- und Decision-Mining mit Winners-only-Realisierung". Das Thema "Best-Practice-Verteilung der Unternehmens-WL auf die gegenwärtig bis zu 4 Computer-Architekturen" ist bei unserem IS-O Consulting nur ein "Neben-Produkt", allerdings ein nicht nur intellektuell hoch interessantes, wie die unglaublichen Fehleinschätzungen praktisch der gesamten IT-Fachwelt, IT-Wissenschaft wie IT-Produkte-Hersteller, in den letzten 20 Jahren zeigt, sondern auch ein kommerziell sehr bedeutendes: Der IT-Anwender-Nutzen beträgt bereits in der deutschen Versicherungs-Branche, wie in der Einführung erwähnt, mindestens € 207,6 Millionen pro Jahr und das IBM (MF+Storage)-Umsatz-Potential mindestens € 76,0 Millionen, wobei knapp 80% hoch-profitabler SSW-Umsatz wäre. Die Profitabilität hat bei gegenwärtigen Preisen einen ROI = 6,4:1.

Bemerkenswert erscheint uns darüber hinaus die Erkenntnis, dass bei einem Vergleich insbesondere der Computer-Architektur-Alternativen MF und x86-Systeme, die seit 10-15 Jahren auch für Enterprise Computing diskutiert werden, der MF in der TPP so viel preiswerter ist, dass er bis zu einer Erhöhung der SSW-Preise um 201% oder 228,7 Mio/Jahr dieses bessere TPP behalten würde. Die dafür notwendige Aufklärung liefern die Geschäftszahlen: Nach unserem umfangreichen Datenmaterial gibt es mehr als 10 Mal so viele installierte MF wie installierte x86-Systeme eingesetzt für Enterprise Computing. Wenn man annimmt, dass die SSW-Entwickler von Microsoft nicht fundamental produktiver sind als ihre Kollegen bei IBM, dann müsste die von ihnen entwickelte SSW bei gleicher Leistungsfähigkeit entweder 10 Mal so teuer verkauft werden oder sie würde bei gleichem Preis nur etwa 1/10 des Leistungsumfanges der MF-SSW beinhalten können. Die Tatsache, dass zur Produktion des gleichen Outputs bei den x86-Systemen in der deutschen Versicherungsbranche 2,5-3 Mal so viele IT-Mitarbeiter benötigt werden, zeigt diese Konstellation mit wissenschaftlicher Eindeutigkeit und die hohe Überlegenheit des MF für Enterprise Computing! Dies ist auch deshalb so bedeutend, da die IT-Personalkosten in der dt. Versicherungsbranche inzwischen bei 59% des IT-Budgets angelangt sind mit weiter steigenden Tendenz. Die objektive Schlussfolgerung daraus lautet: Die MF-Anbieter sollten noch wesentlich mehr Productivityware anbieten, denn dafür gibt es offensichtlich einen erheblichen Bedarf zu attraktiven Preisen.

Diese Erkenntnisse über das MF-Geschäfts-Potential für die dt. VB lassen sich natürlich auch auf den Unternehmens-IT-Einsatz weltweit hochrechnen. Nach unserem seit über 30 Jahren eingesammelten Datenmaterial beträgt das IBM (MF+Storage)-Umsatz-Potential zwischen $ 8,9 Mrd und $ 26,2 Mrd pro Jahr: Bei einem IBM Umsatz 2015 von $ 81,7 sind das offensichtlich keine Peanuts.

Unser Hauptprodukt bleibt aber die "Verfügbarmachung von Entscheidungs-Erkenntnissen zur Realisierung des IT-Unternehmens-Nutzens auf Best-Practice-Niveau durch Data- und Decision-Mining" und adressiert ein IT-strategisch und volkswirtschaftlich noch viel wichtigeres und größeres "zusätzliches IT-Anwender-Nutzen-Potential von bis zu ca. 38-45% des Aufwandes für die Angestellten der Unternehmen" abhängig von der Qualität des Realisierungs-Teams und dem investierten Aufwand. Zur Realisierung dieses IT-Anwender-Nutzen-Potentials müssten die IT-Unternehmens-Investitionen um ca. 65% erhöht werden. Die Profitabilität dürfte bei den ersten Realisierungs-Projekten bei einem ROI = 4:1 angesiedelt sein und gegen Ende auf einen ROI = 2:1 zurückgehen.

- Wiederum eine Winners-only-Situation!

Eine ausführliche Beschreibung des von uns entwickelten "Methodischen Lösungsansatzes zur Gewinnung der Entscheidungs-Erkenntnisse zur Realisierung des IT-Unternehmens-Nutzens auf Best-Practice-Niveau" haben wir unter www.is-oc.com veröffentlicht. Dazu gehört auch ein "IT-Unternehmens-Nutzen-Rechner" zur Ermittlung des individuellen unausgeschöpften IT-Unternehmens-Nutzen-Potentials.

Zusammengefasst:

Die Vision unseres IS-Optimierungs-Consultings sind "Unternehmens-IT Best-Practice"-Lösungen mit

"Winners-only-Realisierungen"

Kommunikation

Der von uns entwickelte Methodische Lösungsansatz zur Realisierung unserer Vision eines IT-Optimierungs-Consultings war von Anbeginn an ausschließlich Daten-basiert! Deshalb war es nur Lösungs-immanent, dass wir die Speicherung der benötigten IT- und Unternehmens-Daten und die Realisierung der Verarbeitungsschritte sukzessive auf Computer übertragen haben. Eine Evolution, die natürlich längst abgeschlossen ist. Ausgesprochen hilfreich war dabei die rasche Entwicklung des Internets bis hin zu den Funktionen "Speicherung in der Cloud" und "Kommunikation per Web-Conferencing", die wir seit langem als integralen Bestandteil unseres Lösungsansatzes einsetzen.

Damit können wir mehrere völlig neuartige Consulting-Alternativen anbieten:

Damit können wir mehrere völlig neuartige Consulting-Alternativen anbieten:

- Ein bisher nicht mögliches "Dynamisches Consulting" das sich durch die oft sehr interessante zusätzliche "What-if-Simulations-Möglichkeit" auszeichnet.

- Ein "Do-it-yourself" Consulting als diskrete "Schnupper-Einführung” oder auch zur "Fortschreibung von schon vorhandenen Ergebnissen".

Auch der Daten- und Erkenntnisse-Gewinnungs-Ansatz ist nach unserem Erkenntnisstand neu:

Auch der Daten- und Erkenntnisse-Gewinnungs-Ansatz ist nach unserem Erkenntnisstand neu:

- Wir gewinnen unser Daten- und Erkenntnis-Material sowohl "durch eigene Forschung, Entwicklung und Auswertungen" als auch durch eine

- "Kollaborative Community": Durch sie haben wir nicht nur Zugang zu qualitativ hochwertigen Daten-basierten Gegenwarts-Erkenntnissen sondern auch zu kreativen Planungs-basierten Zukunfts-Erkenntnisse.

Interessenten empfehlen wir zur Kontaktaufnahme unsere eMail-Adresse info@is-oc.com.

Anmerkung: Twitter und Facebook erscheinen uns eher ungeeignet.